I卡 B580 在 Windows 上部署 IndexTTS

前言

前段时间冲着性价比买了 Intel 的 Arc B580,期望能够满足日常的使用的同时玩一玩大模型。

查询 Intel 官方文档发现 B系列 还不支持 WSL2 ,经过几番折腾确实跑不起来, 因此只能暂时在 Windows 下使用。

实操

IndexTTS 官方未提供 Windows 教程。 翻仓库的 issue 列表找到有人已经踩过坑了,因此参考该教程: issue 143

本人选择使用 mamba

# 安装 mamba,本人选择直接使用默认安装位置,大家可自行选择合适的安装位置

Invoke-Expression ((Invoke-WebRequest -Uri https://micro.mamba.pm/install.ps1 -UseBasicParsing).Content) 安装完之后,下载 IndexTTS 源码

git clone https://github.com/index-tts/index-tts.git创建虚拟环境

注, issue 里使用了python3.12环境,经过实测,3.12 无法通过 torch(xpu) 的编译,本人选择降级到 3.10

使用 pip 安装依赖时可根据自己的网络环境选择镜像源

micromamba create -n index-tts-xpu python=3.10

micromamba activate index-tts-xpu安装 pytorch-xpu

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/xpu按照教程安装 WeTextProcessing 依赖

windows上编译不通过,无法使用,需要从 conda-forge 安装

micromamba install -c conda-forge pynini==2.1.6

pip install WeTextProcessing --no-deps

pip install importlib_resources==6.5.2安装项目依赖

pip install -r requirements.txt从 modelscope 下载模型

这里使用1.5版本的模型

# 使用 modelscope 脚本下载

pip install modelscope

modelscope download --model IndexTeam/IndexTTS-1.5 --local_dir ./IndexTTS-1.5

# git 下载需要安装 git-lfs

# git clone https://www.modelscope.cn/IndexTeam/IndexTTS-1.5.git 修改一下 webui.py 的代码,把 device 改成 xpu

diff --git a/webui.py b/webui.py

index 94b2ab4..16d7273 100644

--- a/webui.py

+++ b/webui.py

@@ -42,7 +42,7 @@ from tools.i18n.i18n import I18nAuto

i18n = I18nAuto(language="zh_CN")

MODE = 'local'

-tts = IndexTTS(model_dir=cmd_args.model_dir, cfg_path=os.path.join(cmd_args.model_dir, "config.yaml"),)

+tts = IndexTTS(model_dir=cmd_args.model_dir, cfg_path=os.path.join(cmd_args.model_dir, "config.yaml"), device="xpu")最后就可以启动 webui 使用了

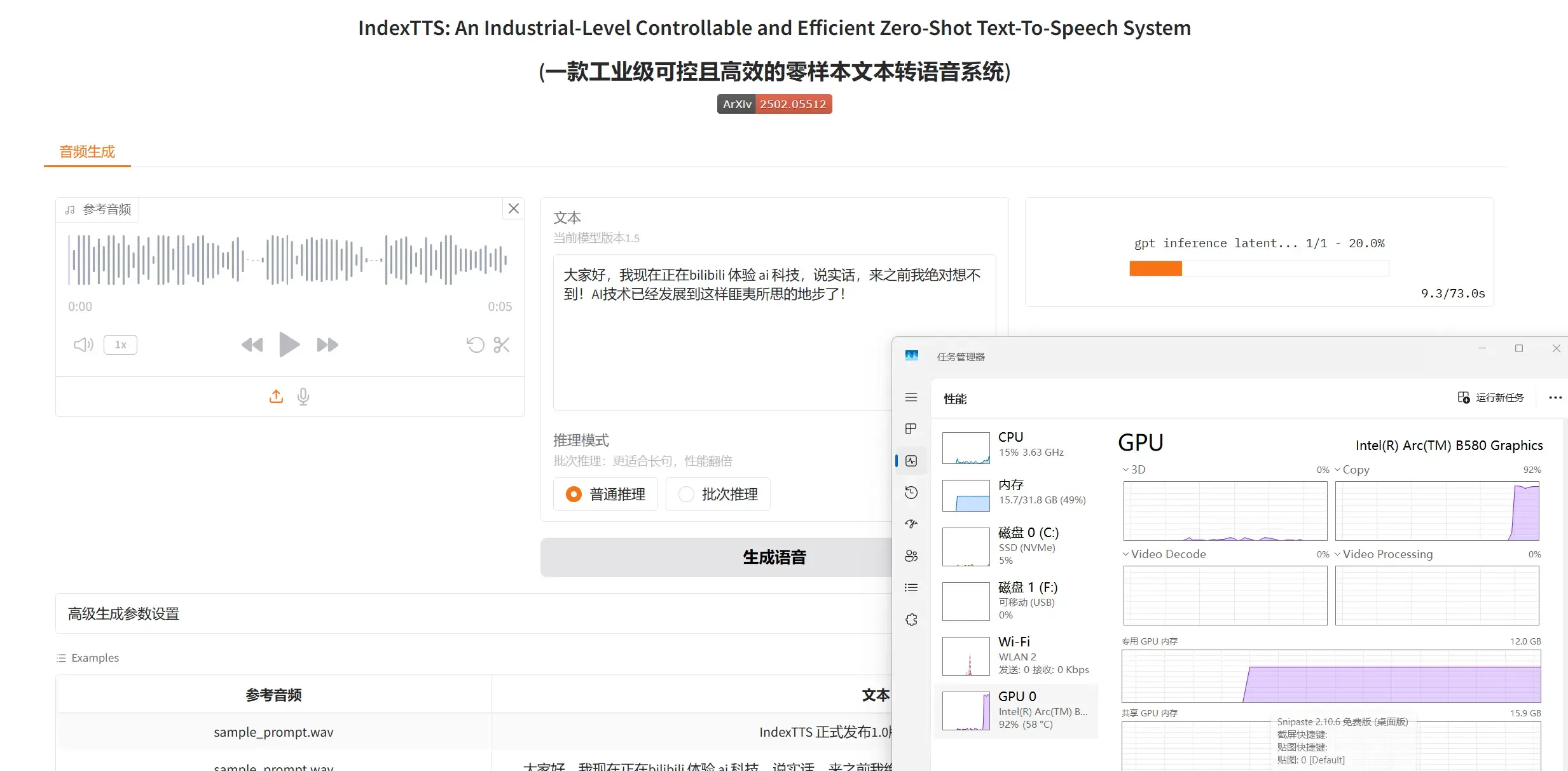

python webui.py --model_dir IndexTTS-1.5最后附上一张成功调用 GPU 加速的截图

速度比较感人😂。 有尝试过使用 vllm 加速,但是 Windows 不支持, WSL2 也不支持,只能等等看了,凑合用吧。